Nächste Ausfahrt Zukunft…

Unsere Kinder und Enkelkinder wachsen in einer spannenden Welt auf: In manchen Haushalten gesellen sich inzwischen Digitale Assistenten wie Amazons Alexa, Google Home oder der Spielzeugroboter Cozmo zum häuslichen Inventar. Sie gehören für einen Teil der heranwachsenden Generation bereits zum „natürlichen“ Umfeld. Interessant ist dabei, wie die Kinder diese „intelligenten“ Apparate wahrnehmen. Immerhin kann man die Apparate ansprechen, ihnen Fragen stellen oder sogar mit ihnen spielen.

„Ist es in Ordnung, wenn ich dich esse?“

Das MIT-Medialab machte in diesem Sommer einen aufschlussreichen Test mit 26 Kindern im Alter zwischen 3-10 Jahren[1]: Die Forscher beobachteten, wie die Kinder mit den Geräten interagierten und sie untersuchten, ob die Kinder diese künstlichen Apparate als freundlich, glaubwürdig oder intelligent bewerten. Die jüngeren Kinder behandelten Alexa & Co wie ein anderes Lebewesen und stellten Fragen wie: „Hey Alexa, wie alt bist du?“ oder „Was ist deine Lieblingsfarbe?“. Bei den Älteren ging es zunehmend auch um die Erkundung von Unterschieden: „Kannst du Türen aufmachen?“ oder „Hast du ein Telefon in dir?“. Ein 6- jähriges Mädchen fragte sogar: „Ist es in Ordnung, wenn ich dich esse?“ Die kindlichen Interaktionen beschränken sich auf die Sprache und das Bedürfnis nach Mitteilung – Tätscheln oder Schmusen bleiben derzeit noch auf der Strecke.

Bei der Studie zeigte sich, dass die Mehrheit der Kinder den Maschinen glauben, sie als freundlich und sogar als intelligenter als sie selbst einstufen. Kinder, die noch nicht alleine ihre Schnürsenkel zubinden oder Fahrradfahren oder lesen können, tauchen immer tiefer ein, in eine neue Welt sprechender, interaktiver Apparate. Im Gegensatz zu den bisher eher stupiden Alltagshelfern, wie Kaffeeautomaten oder Staubsaugern, beginnen sie, zu den sprechenden Assistenten eine Beziehung aufzubauen. Die intelligenten Begleiter lesen ihnen Geschichten vor, spielen Musik, erzählen Witze und verführen zum Einkaufen. Amazon hat inzwischen sein Echo-System mit einer Kamera erweitert.

„Alexa, was soll ich heute tragen: das pinke oder das gelbe Kleid?“ Amazon Echo Look, so der Hersteller, nutzt bei der Beantwortung derartiger Fragen angeblich intelligente Style-Check Algorithmen, die von Mode-Spezialisten eintrainiert wurden. Vorbei also die langen Spiegel-Sessions unserer Töchter, mit der unlösbaren morgendlichen Frage: „Was soll ich anziehen?“ Der Apparat kennt den Inhalt ihres Kleiderschranks, kombiniert und beurteilt und gibt ganz nebenbei Tipps zu aktuellen Sonderangeboten. Der nette Babysitter ist ein getarnter Verkäufer, der uns Tag und Nacht im eigenen Heim „berät“. Amazon hat inzwischen sieben eigene Modelabels gegründet und will künftig Kinder und Erwachsene einkleiden.

„Alexa, was soll ich heute tragen: das pinke oder das gelbe Kleid?“ Amazon Echo Look, so der Hersteller, nutzt bei der Beantwortung derartiger Fragen angeblich intelligente Style-Check Algorithmen, die von Mode-Spezialisten eintrainiert wurden. Vorbei also die langen Spiegel-Sessions unserer Töchter, mit der unlösbaren morgendlichen Frage: „Was soll ich anziehen?“ Der Apparat kennt den Inhalt ihres Kleiderschranks, kombiniert und beurteilt und gibt ganz nebenbei Tipps zu aktuellen Sonderangeboten. Der nette Babysitter ist ein getarnter Verkäufer, der uns Tag und Nacht im eigenen Heim „berät“. Amazon hat inzwischen sieben eigene Modelabels gegründet und will künftig Kinder und Erwachsene einkleiden.

Hinter der Hilfsbereitschaft des Roboters versteckt sich also, wer hätte es gedacht, ein latent kommerzielles Interesse. Unsere Kinder vertrauen den Apparaten, deren Algorithmen sich nicht der Wahrheit verschreiben, sondern lediglich unser Konsumverhalten weiter anheizen wollen. Wie aber vermitteln Eltern Ihren Kindern das Hinterfragen dieser Marketing-Roboter, wenn diese einen immer größeren Stellenwert in unserem Leben einnehmen? Wie lernen wir die Botschaften von Alexa & Co kritisch zu überprüfen, wenn bereits unsere Kinder dem Roboter blind vertrauen?

Wir werden Zeugen eines Konditionierungseffektes, der, in vielen Bereichen unseres Lebens, Wissen und Verständnis durch ein blindes Vertrauen in die Maschine oder in einen Algorithmus ersetzt. Vertrauen statt Verstehen. Wie akut diese Verschiebung ist, offenbart sich bei modernen KI-Systemen. Viele von ihnen basieren auf sogenannten digitalen neuronalen Netzwerken, einer mathematischen Modellierung unserer bislang verstandenen Gehirnstruktur.

neuronale Netzwerke

Stark vereinfacht kann man sich ein neuronales Netzwerk wie eine Blackbox vorstellen, wobei ein »Eingangsmuster« ein »Ausgangsmuster« erzeugt. Diese magische Blackbox ist faszinierend und wird immer besser bei der Zuordnung. In einigen Anwendungen haben Maschinen den Menschen schon jetzt überholt. Beim Erkennen von Verkehrsschildern, der Auswertung von Rechtsdatenbanken oder bei der Identifizierung von Tumoren auf Röntgenaufnahmen ist die Maschine inzwischen treffsicherer als der Mensch. Doch bei tiefen neuronalen Netzwerken, mit manchmal über zwanzig hintereinandergeschalteten Schichten, lässt sich nicht mehr genau vorhersagen, was auf diesen nachgeschalteten Ebenen tatsächlich passiert. Angesichts dieser Komplexität versagt die genaue Beschreibung von Ursache und Wirkung, und so rätseln die Erbauer über das Verhalten ihrer eigenen Maschine. Ein Freund, der bei einem der großen Softwareunternehmen als Programmierer arbeitet, spricht von »digitaler Alchemie«. Wir vertrauen also Apparaten, die wir in der Tiefe nicht mehr verstehen.

Wir vertrauen also Apparaten, die wir in der Tiefe nicht mehr verstehen….

Es mutet an wie ein Widerspruch: Mit dem kausalen Denken versuchten wir die Geister der Vergangenheit zu vertreiben, und nun akzeptieren wir sie im Innern unserer Software. Obwohl wir die digitalen neuronalen Netze nicht wirklich durchschauen, werden diese labilen Systeme schon in kommerziellen Anwendungen oder im Dienste der Sicherheit eingesetzt. Kfz-Kennzeichen werden inzwischen mittels Bilderkennung bei Mautstellen und Parkautomaten erfasst, und im Namen der Sicherheit beginnt man weltweit damit, die Aufnahmen von Überwachungskameras auszulesen und mit unzähligen weiteren Datenspuren zu kombinieren. Anlässlich einer deutsch-amerikanischen Konferenz, die von Studenten an der Harvard-Universität organisiert wurde, sprach ich mit Alexander Graubner-Müller. Er ist der Gründer von Kreditech, einem der erfolgreichsten deutschen Startups im Bereich Finanzdienstleistungen.75 Dieses Unternehmen nutzt Kundendaten aus dem Internet und den sozialen Netzwerken wie Facebook und Twitter, um in erstaunlichem Tempo Kreditentscheidungen zu fällen. Dazu wurde eine eigene Kredit-Scoring-Technologie entwickelt, die maschinelles Lernen auf der Basis neuronaler Netzwerke einsetzt. Ein komplizierter Algorithmus ermögliche, wie Alexander mir erläuterte, das Kreditrisiko eines Kunden binnen einer Minute mit höherer Präzision zu bestimmen, als herkömmliche Methoden zur Überprüfung der Kreditwürdigkeit. »Doch was, wenn mein Kredit abgelehnt wird – sagt ihr mir auch, warum?«, fragte ich ihn. Seine Antwort verblüffte mich: Abgesehen von Einzelfällen, könne man angesichts der Komplexität der verwendeten Daten keinen eindeutigen Grund für die Kreditentscheidung nennen.

Wir leben in einer aufgeklärten Gesellschaft und vertrauen immer mehr dem technischen Orakel. In der griechischen Mythologie war es Apollon, der in Delphi die Schlange Python tötete. Ihr Blut sickerte in den Boden, und so übertrugen sich ihre prophetischen Fähigkeiten auf diesen Ort. Inzwischen hat ihr Blut auch die feinen Verästelungen unserer Apparate erreicht …Übrigens: Delphi und Python sind Programmiersprachen, Oracle ist ein Softwareunternehmen.

Dürfen wir, die Urenkel von Leibniz, eine Entwicklung zulassen, die das Fundament der Aufklärung derartig in Frage stellt? Sind Maschinen oder Algorithmen, die zwar in der Bilanz häufig richtigliegen, akzeptabel, wenn wir Menschen ihre Wirkungsweise weder genau verstehen noch kausal erklären können? Für den Geschäftsmann spielen solche Überlegungen kaum eine Rolle, denn in den Kategorien des ökonomischen Denkens ist ein undurchschaubarer Apparat mit einer Trefferquote von 90% allemal besser als ein durchschaubares System, welches nur in 70% aller Fälle richtigliegt. Für das Business reicht nämlich einzig die Trefferquote, um Kaufempfehlungen zu geben oder Konsummuster zu erstellen. Wenn die Kaufquote steigt ist das in Ordnung, und zwar auch dann, wenn man die darunterliegenden Mechanismen nicht erklären kann und auch dann, wenn als Kollateralschaden sogar fehlerhafte Empfehlungen damit einhergehen. Hauptsache die Bilanz stimmt.

Deep learning

Deep learning sprudelt inzwischen mit allerlei Anwendungen, von der Gesichtserkennung, dem Identifizieren des Alters, Vorhersagen über Selbstmordrisiko oder Drogenkonsum eines Menschen oder der automatischen Sprachübersetzung in Echtzeit. Jeder, der sich genauer damit befasst, kann sich der Faszination kaum entziehen. Erinnern wir uns: Das System Alpha-Go schlug im März 2016 den menschlichen Meister Lee Sidol im Brett Spiel Go. Diese Nachricht markierte einen neuen Höhepunkt innerhalb der Disziplin der künstlichen Intelligenzforschung. Damals lernte das System zunächst aus den vielen dokumentierten menschlichen Spielen der Vergangenheit. Bei diesem sogenannten „supervised learning“ fütterte man den Apparat mit 29 Millionen Spielzügen. Der Apparat lernte also von uns Menschen.

Nur ein Jahr später wurde eine weitere Stufe erreicht. Die neue Version Alpha Go Zero verzichtete auf den klassischen Lernprozess und nutzte nicht mehr menschliches Erfahrungswissen, sondern erlernt das Go-Spiel selbständig. Dabei wurden Alpha-Go Zero lediglich die Spielregeln einprogrammiert. Nach nur 36 Stunden war das neue selbstlernende System bereits besser als sein Vorgänger Alpha-Go und gewann jede Partie. Alpha-Go Zero entdeckte nicht nur bekannte Strategien des Go-Spiels, sondern auch neue, unbekannte Spielzüge. Der Titel der wissenschaftlichen Veröffentlichung[2] lautet: „Beherrschung des Go-Spiels ohne menschliches Wissen“. Alpha Go Zero verzichtete auf den klassischen Lernprozess und nutzt nicht mehr menschliches Erfahrungswissen. Es lernt aus der eigenen Erfahrung, die anders ist als die menschliche. Auch wenn es „nur“ ein Spiel ist, so zeigt sich, dass Maschinen aufgrund der hohen Leistung, menschliche Erfahrungen binnen kürzester Zeit eigenständig „erlernen“. Bemerkenswert ist das Ende der Nature-Publikation:“ … Die Menschheit hat über Jahrtausende aus Millionen von Spielen gelernt, hat daraus Muster, Spielzüge und ganze Bücher entwickelt. In nur wenigen Tagen, auf der Basis von tabula rasa (Anm. also ohne Erfahrung) ist es Alpha-Go gelungen, das menschliche Go-Wissen selbst zu entdecken und darüber hinaus auch neue Einblicke in das älteste aller Spiele zu gewinnen.“

Korrelation ersetzt Kausalität…

Kein Zweifel – diese Maschinen sind faszinierend, doch – und darin liegt eine gewisse Ironie – wir Menschen verstehen nicht genau, wie sie funktionieren. Legitimiert die unbestrittene Leistungsfähigkeit dieser Systeme auch deren Einsatz im Alltag? Darf ein Rechtssystem Algorithmen einsetzen, um zum Beispiel potenzielle Gefährder zu identifizieren, wenn die Grammatik dieser Systeme im Unklaren bleibt? Dürfen wir akzeptieren, dass in dieser Bilanz vielleicht tatsächlich mehr potentielle Straftäter herausgesiebt werden, doch dafür auch Unschuldige im Netz der Verdächtigungen hängenbleiben? Dürfen wir das fundamentale Prinzip der Kausalität – immerhin die Basis unserer aufgeklärten Gesellschaft – zu Gunsten eines scheinbar potenteren Korrelationsdenkens opfern?

Wie aktuell diese Frage ist, zeigt sich in der Europäischen Datenschutzgrundverordnung, die am 25. Mai 2018 anwendbar wird. In Artikel 22 (Automatisierte Entscheidungen im Einzelfall einschließlich Profiling) geht man dem Kern des Kausal-Problems aus dem Weg, denn im ersten Abschnitt heißt es lediglich: Die betroffene Person hat das Recht, nicht einer ausschließlich auf einer automatisierten Verarbeitung – einschließlich Profiling – beruhenden Entscheidung unterworfen zu werden, die ihr gegenüber rechtliche Wirkung entfaltet oder sie in ähnlicher Weise erheblich beeinträchtigt[3].

Warum steht hier nicht die elementare Forderung: „Jeder Algorithmus, der zur Anwendung kommt, muss nach kausalen Prinzipien erklärbar sein“?

Ist es nicht unser aller Pflicht, die Grundpfeiler des Rechtsstaates, also Transparenz und eindeutige Kausalketten, als Basis unserer Entscheidungen zu wahren und diese mit aller Entschiedenheit auch über ein ökonomisches Bilanzdenken zu stellen? Wenn wir Maschinenentscheidungen, die wir nicht mehr nachvollziehen, zur neuen Basis erklären, dann öffnen wir die Tür in ein Zeitalter digitaler Orakel und willkürlicher Entscheidungen. Demokratie braucht eine Rechenschaftspflicht und diese muss auch für unsere Werkzeuge gelten.

XAI: explainable artificial intelligence

Inzwischen wird einigen Insidern die Brisanz des Problems klar. Als ich vergangene Woche in Stanford mit einigen Forschern sprach, tauchte eine neue Vokabel auf: XAI „explainable artificial intelligence“. Dahinter verbirgt sich eben jene Forderung, auch im Reich des Maschinenlernens Prozesse und Entscheidungsketten im Detail zu verstehen und nachvollziehen zu können. Inzwischen beginnen also einige Forscher damit, das trübe Innenleben neuronaler Systeme auszuleuchten, um die genaue Wirkungsweise ihrer Prozesse zu begreifen. Manchmal stoßen die Wissenschaftler dabei auf erstaunliche Einsichten: Bei der Identifizierung von Menschen auf Bildern fand zum Beispiel eine Gruppe heraus, dass der Algorithmus bei der Kategorisierung von Menschen auf Bildern auch das Vorhandensein von Stoff-falten mit einbezieht. Schauen sie ihren Nachbarn genauer an: Stoff-falten als Indiz für einen Menschen! Die Kategorien der Maschine sind, wie gesagt, anders als die von uns Menschen!

Vielleicht liefert ausgerechnet Leibniz eben jene Klarheit, die uns heute im Lichte der neuen Wundermaschinen verloren geht: Im Paragraf 17 seiner Monadologie[4] von 1714 verneint er, dass man “denkende Maschine” “konzipieren” könne, “aus deren Struktur gewisse Gedanken, Empfindungen, Perzeptionen erwüchsen” da kein Element einer Maschine, die aus Teilen (“Stücken”) besteht, “deren eines an das andere stoßet”, “eine Perzeption oder Empfindung erklären” kann. Im Lichte von Leibniz müssen wir die Frage neu stellen: Mensch und Maschine – wer programmiert am Ende wen?

Denn unbemerkt beginnen eben diese Maschinen damit, uns Menschen, unser Zuhause, unser Verhalten und unsere Biographien zu erfassen und als berechenbare Objekte zu behandeln. In der Gedankenwelt der Maschine werden auch wir selbst in messbare Eigenschaften aufgespalten, in einzelne Kategorien zerlegt, auf ein digitales Objekt reduziert und in Clouds und Serverfarmen abgebildet. Wir selbst sind zudem die Datenlieferanten dieses wachsenden digitalen Alter-Egos und je mehr wir die Automaten nutzen und in unseren Alltag integrieren, umso genauer wird das entsprechende Datenmosaik.

Wenn der Apparat uns nicht versteht, dann passen wir uns eben an und übernehmen seine Grammatik. Aus Bequemlichkeit nutzen wir seine Textvorschläge, besuchen seine Restaurants oder kaufen das, was er uns empfiehlt. Noch klicken und wischen wir uns durch die virtuellen Welten, doch der Apparat nimmt bereits neue Formen an und erweitert seine Sinne. Wenn er unser Gesicht sieht, dann entsperrt er unser Telefon und wenn er unsere Stimme hört, weiß er, wer ihn anspricht. Die Schnittstelle zwischen der warmen und kalten Welt, das User-Interface, wird laufend erweitert. Das Erkennen von Sprache hat sich inzwischen enorm verbessert. Entzifferte der Apparat vor wenigen Jahren nur ein Bruchteil unserer Worte, so hat sich die Fehlerquote inzwischen substanziell reduziert. Spracherkennung ist alltagstauglich geworden. Die fulminanten Erfolge künstlicher Spracherzeugung zeigen eine weitere Qualität, denn immer mehr Menschen wissen nicht mehr, ob hier ein Mensch oder eine Maschine antwortet. Während meiner Vorträge demonstriere ich eine Reihe praktischer Beispiele:

Nachdem das Publikum Sätze und kurze Musikpassagen hört, stelle ich die Frage: Mensch oder Maschine? Das Votum des Publikums offenbart, wie schwer es uns inzwischen fällt, diesen Unterschied noch herauszuhören. Die neuen künstlichen Stimmen haben ihren monotonen Robotersound längst abgelegt. Sie atmen und seufzen wie ein Mensch und in wenigen Jahren dürften wir wohl nicht mehr wissen, ob der nette Mitarbeiter am anderen Ende noch ein Mensch ist oder lediglich ein kalter intelligenter Apparat.

Nachdem das Publikum Sätze und kurze Musikpassagen hört, stelle ich die Frage: Mensch oder Maschine? Das Votum des Publikums offenbart, wie schwer es uns inzwischen fällt, diesen Unterschied noch herauszuhören. Die neuen künstlichen Stimmen haben ihren monotonen Robotersound längst abgelegt. Sie atmen und seufzen wie ein Mensch und in wenigen Jahren dürften wir wohl nicht mehr wissen, ob der nette Mitarbeiter am anderen Ende noch ein Mensch ist oder lediglich ein kalter intelligenter Apparat.

Als ich im Oktober ein Software-Unternehmen in der indischen IT-Metropole Bangalore besuchte, führte man mir einen neuen Prototyp vor, einen sprechenden Finanzfach-„mann“. Bei diesem Ansatz wollen die Techniker in Zukunft vollständig auf die Eingabe per Tastatur verzichten und setzen mit viel künstlicher Intelligenz auf ein „natürliches“ Zusammenspiel zwischen Mensch und Maschine. Bei meinem Dialog mit dem Apparat verlief vieles genauso wie beim Gespräch mit einem Experten aus Fleisch und Blut. Keine einsilbigen Befehle, sondern natürliche Sprache. Das System verstand sogar den mitunter versteckten Inhalt meiner Fragen und gab Antwort, ohne dass ich in den üblichen Befehlsmodus wechseln musste. Hätte dieser Apparat hinter einem Vorhang gestanden, so wäre es mir schwer gefallen zu entscheiden, ob sich dahinter ein Mensch oder eine Maschine verbirgt. Doch es gab einen Unterschied: Dieser Apparat war schneller und präziser als sein biologisches Vorbild.

Digitale Evolution…

Was viele von uns verkennen, ist die Selbstbeschleunigung der digitalen Evolution: Maschinen lernen inzwischen schneller als wir Menschen und beginnen allmählich, das Erfahrungswissen von uns Menschen durch die eigene Erfahrung zu ersetzen.

Lassen Sie mich ein weiteres Beispiel aus einem anderen Bereich nennen und auch hier geht es erneut um die Polarität zwischen Fortschritt und Verständnis: Steve Horvath von der UCLA hat gemeinsam mit seinem Team bemerkenswerte Fortschritte beim Verständnis des Alterungsprozesses gemacht. Die epigenetische Uhr könnte ein Schlüssel im Verständnis von Alterungserscheinungen sein und Nature bezeichnet den Wissenschaftler als Clock watcher[5]. Die einfache Frage „Wie alt bin ich?“ erfährt nämlich derzeit eine neue Interpretation. Mit Hilfe der DNA-Methylierungs-modifikation lässt sich nun eine Art biologisches Alter ablesen. Die Hoffnung: Das genaue Verständnis der epigenetischen Uhr könnte womöglich langfristig zu neuen Medikamenten und so zu einer Altersverlangsamung führen. Als ich vergangene Woche in Stanford drehte, hörte ich gleich von mehreren Wissenschaftlern die wagemutige These: Altern ist eine Krankheit und wir wollen sie heilen! Tony Wiss-Coray wies in ersten Experimenten nach, dass Bestandteile des Blutplasmas junger Mäuse bei alten dementen Mäusen sogar eine Umkehr der Demenz verursachen. Junges Blut heilt, die Organe verjüngen sich und selbst im Gehirn findet ein bislang immer noch nicht verstandener Verjüngungsprozess statt. Das alles klingt nach moderner Alchemie und es ist kein Zufall, dass sein ausgegründetes Unternehmen „Alkahest“ heißt, benannt nach dem Elixier des Lebens. Obwohl Tony und sein Team noch am Beginn der Forschung stehen, sorgen ihre ersten Tests an Menschen für Aufregung. Anfang November berichtete das Team von ersten klinischen Tests[6] an insgesamt 18 Patienten. Hierbei ging es um die Sicherheit der Plasmagabe, also eine Voruntersuchung, doch bereits hier offenbaren sich Hinweise auf erste positive Effekte. Interessanterweise öffnet sich, wenn es so weitergeht ein Dilemma: Was, wenn die Gabe der Plasmabestandteile hilft, obwohl man den zugrundeliegenden Mechanismus noch nicht versteht? Sollen demente Menschen solange warten, bis die Wissenschaft eine eindeutige Antwort liefert? Schon jetzt, so verriet mir Tony erhalte er Anrufe von Patienten oder deren Familien – Betroffene sind verständlicherweise ungeduldig.

Lassen Sie mich ein weiteres Beispiel aus einem anderen Bereich nennen und auch hier geht es erneut um die Polarität zwischen Fortschritt und Verständnis: Steve Horvath von der UCLA hat gemeinsam mit seinem Team bemerkenswerte Fortschritte beim Verständnis des Alterungsprozesses gemacht. Die epigenetische Uhr könnte ein Schlüssel im Verständnis von Alterungserscheinungen sein und Nature bezeichnet den Wissenschaftler als Clock watcher[5]. Die einfache Frage „Wie alt bin ich?“ erfährt nämlich derzeit eine neue Interpretation. Mit Hilfe der DNA-Methylierungs-modifikation lässt sich nun eine Art biologisches Alter ablesen. Die Hoffnung: Das genaue Verständnis der epigenetischen Uhr könnte womöglich langfristig zu neuen Medikamenten und so zu einer Altersverlangsamung führen. Als ich vergangene Woche in Stanford drehte, hörte ich gleich von mehreren Wissenschaftlern die wagemutige These: Altern ist eine Krankheit und wir wollen sie heilen! Tony Wiss-Coray wies in ersten Experimenten nach, dass Bestandteile des Blutplasmas junger Mäuse bei alten dementen Mäusen sogar eine Umkehr der Demenz verursachen. Junges Blut heilt, die Organe verjüngen sich und selbst im Gehirn findet ein bislang immer noch nicht verstandener Verjüngungsprozess statt. Das alles klingt nach moderner Alchemie und es ist kein Zufall, dass sein ausgegründetes Unternehmen „Alkahest“ heißt, benannt nach dem Elixier des Lebens. Obwohl Tony und sein Team noch am Beginn der Forschung stehen, sorgen ihre ersten Tests an Menschen für Aufregung. Anfang November berichtete das Team von ersten klinischen Tests[6] an insgesamt 18 Patienten. Hierbei ging es um die Sicherheit der Plasmagabe, also eine Voruntersuchung, doch bereits hier offenbaren sich Hinweise auf erste positive Effekte. Interessanterweise öffnet sich, wenn es so weitergeht ein Dilemma: Was, wenn die Gabe der Plasmabestandteile hilft, obwohl man den zugrundeliegenden Mechanismus noch nicht versteht? Sollen demente Menschen solange warten, bis die Wissenschaft eine eindeutige Antwort liefert? Schon jetzt, so verriet mir Tony erhalte er Anrufe von Patienten oder deren Familien – Betroffene sind verständlicherweise ungeduldig.

younger than ever…

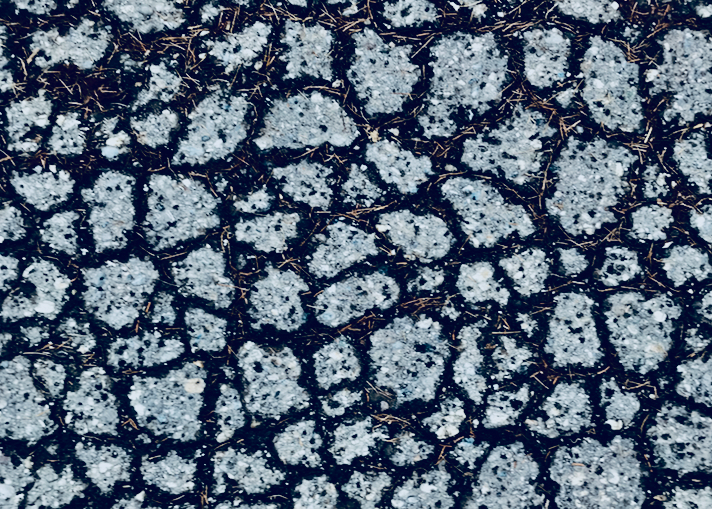

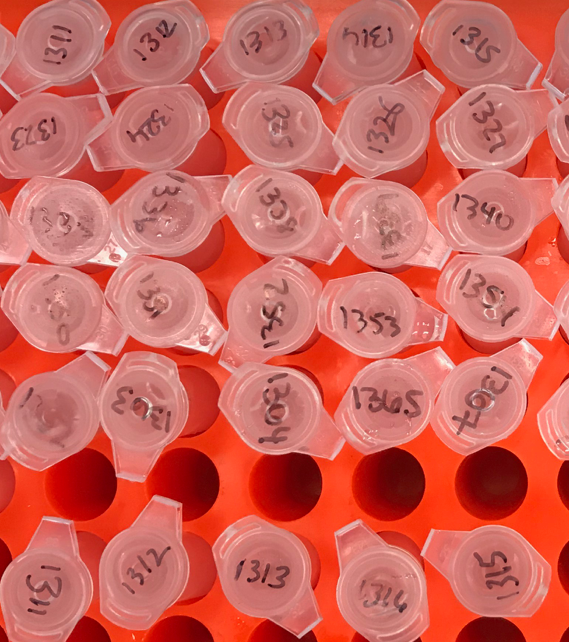

Nochmals zur epigenetischen Uhr und zu Steve Horvath. Der Forscher arbeitet an der UCLA und erläuterte mir, dass die Universität die Patente an seiner Forschung besitzt. Obwohl es sich im Moment immer noch um Grundlagenforschung handelt, wurden einige Patente bereits kommerzialisiert, so z.B. in einem Test-Kit namens DNAge. Eine einfache Blut- oder sogar Urinprobe reicht aus. Dieser Test nutzt dabei moderne Sequenzier-Techniken und erfasst 500 Stellen im menschlichen Genom, die epigenetischen Veränderungen unterliegen, um somit das biologische Alter einer Person zu bestimmen. Den Test können sie im Internet anfordern. Die Seite lautet mydnage.com und mit 299$ sind sie dabei.

Ich selbst habe diesen Test im Rahmen einer Sendung gemacht – sehr bewusst – und wenige Tage später erreichte mich das Ergebnis: Zur Information: Ich bin 1959 geboren und 58 Jahre alt. Bereits eine Woche nach Einsendung der Blutprobe kam via Mail die lapidare Antwort:

Ich selbst habe diesen Test im Rahmen einer Sendung gemacht – sehr bewusst – und wenige Tage später erreichte mich das Ergebnis: Zur Information: Ich bin 1959 geboren und 58 Jahre alt. Bereits eine Woche nach Einsendung der Blutprobe kam via Mail die lapidare Antwort:

Based on the methylation value of your sample, your DNAge™ is 54 .

Toll! Ich bin also jünger! 54 statt 58! In meinem Alter kann das durchaus euphorische Reaktionen hervorrufen. Doch auf der grafischen Darstellung des Messfehlers war im Kleingedruckten zu lesen: Der graue Balken zeigt den Median von 2 Standardabweichungen. Trotz der erfreulichen Nachricht muss ich also gestehen, dass das verjüngende Ergebnis in meinem Fall kaum wirklich signifikant ist . Als ich wenig später mit Steve über dieses Ergebnis sprach, entbrannte zwischen uns eine lebhafte Diskussion. Der exzellente Grundlagenforscher distanzierte sich vom kommerziellen Test – obwohl dieser sogar seinen Namen explizit aufführte. Die Vermengung von sinnvoller Grundlagenforschung und absurden Tests fand ich schon beachtlich doch Steve versicherte mir, dass er selbst kein Geld damit verdienen würde.

Erneut erleben wir ein bekanntes Muster: Grundlagenforschung, die in vielerlei Hinsicht noch nicht einmal verstanden wurde, wird bereits kommerzialisiert. Ein Testkit zur Altersbestimmung, zukünftige Plasmagaben gegen das Altern oder eben ein neuronales Netz zur Kundenoptimierung. In allen Fällen konstatiere ich ein vorschnelles Handeln. Da gibt es bereits ein Produkt und ein Business Modell, obwohl elementare Verständnisfragen oder gar ethische Aspekte im Unklaren bleiben. Was, bitte schön, könnte ein Alterstest in einem Menschen auslösen, wenn sein ermitteltes biologisches Alter womöglich deutlich älter ist als das Alter in seinem Reisepass? Zudem gibt es momentan keinerlei aktive Handhabe für den Betroffenen. Man wird mit dem Ergebnis alleine gelassen, die Alterszahl wird zu einem Verdikt, ein modernes memento mori, welches womöglich Krankenversicherungen neue Dimensionen eröffnet. Vielleicht werden die zukünftigen Tarife an dieses biologische Alter angepasst. In meinem Fall würde es dann günstiger. Und was, wenn die Verjüngung per Blutplasma nicht nur bei Demenzkranken eingesetzt wird? Was wenn reiche Jungmanager – und davon gibt es im Silicon Valley viele, auf den Geschmack der neuen Kur kommen?

reflektierter Fortschritt…

reflektierter Fortschritt…

Kennen Sie Methylphenidat? Vielleicht doch, als Präparat namens Ritalin. Im Jahr 1993 wurden in ganz Deutschland gerade mal 34 Kilogramm Methylphenidat im Jahr verschrieben und konsumiert. Für die Wunderdroge begann ein einzigartiger Siegeszug. Inzwischen liegt der Jahresverbrauch alleine in Deutschland bei aberwitzigen 1,8 Tonnen! Das entspricht etwa 60 Millionen Tagesdosen. Täglich schlucken mehr als 150 000 Schüler oder Studenten die Wunderpille, um damit konzentrierter und besser zu lernen. Aus dem Konsum von Methylphenidat ist inzwischen ein Milliardendollargeschäft geworden, und Fachleute beklagen, dass das Präparat bei angeblichen Verhaltensproblemen zu rasch verschrieben wird. Wie schnell könnten wir ähnliches bei Plasma-Verjüngungskuren erleben…Anstelle eines reflektierten Fortschritts und gesicherter Erkenntnis wird viel zu früh mitunter Halbwissen in Produkte gegossen – Fake-Science könnte man so etwas bezeichnen.

Wo aber bleiben die kritischen Stimmen aus der Wissenschaft selbst? Wo stehen Mathematiker, Mediziner oder Biochemiker auf und sagen Stopp – Kein Produkt ohne klares Verständnis, keine Anwendung ohne auch ihre ethischen Implikationen zu hinterfragen. Inmitten unserer phänomenalen Innovationsflut droht der kritische Sachverstand überhört zu werden, denn das schnelle Business eilt immer voraus. Sie alle kennen dutzende Beispiele hierfür; man denke nur an die aktuellen Patentstreitigkeiten im Rahmen von CRISPR-CAS oder den, wie ich finde, vorschnellen Bericht zur Ethik des autonomen Fahrens. In einer Welt, wo neue Produkte in nur wenigen Jahren die 100 Millionen Nutzer-Grenze durchbrechen, gibt es wohl immer weniger Zeit zum Nachdenken. Wo aber bleibt in einem solchen Klima der reflektierte Fortschritt? Liegt nicht gerade hier eine wichtige Verantwortung der Wissenschaft?

Am 22. April 2017, im Rahmen des March for Science, sagte ich hier in Berlin in meiner Rede am Brandenburger Tor:

„Wir dürfen nicht zulassen, dass Populisten unsere Welt gefährlich vereinfachen und so unsere Gesellschaft spalten, das sind wir der Suche nach der Wahrheit schuldig.“ Vielleicht hätte ich Populisten durch Krämer ergänzen sollen: Wir dürfen nicht zulassen, dass Krämer oder das schnelle Geschäftemachen unsere Welt gefährlich vereinfachen und so unsere Gesellschaft spalten, das sind wir der Suche nach der Wahrheit schuldig.” Im Sog der Fortschrittswelle ist es an der Zeit, unser Handeln und die Ziele genauer zu überdenken.

Ich begann meine Rede mit Alexa, dem wunderbaren digitalen Butler, der vermutlich in diesem Jahr unter manchem Christbaum stehen wird. Alexa wird nicht lange alleine bleiben. Kaffeeautomaten, Zahnbürsten, Kochautomaten aber auch Fräsmaschinen, Antriebsaggregate, Heizungssysteme oder Röntgenapparate, sie alle werden ihren Zustand weitermelden und uns beraten und begleiten. Ganze Industriezweige und Produktionsprozesse werden in den kommenden Jahren Schritt für Schritt von Maschinen und intelligenten Algorithmen übernommen. Die Medizin dürfte in den kommenden Jahren durch eine Flut neuer Diagnoseverfahren und intelligenter Therapien massiv erweitert werden. Was uns bevorsteht, ist also keine kleine technische Verbesserung, kein Optimieren des business as usual, sondern eine epochale Neusetzung in der Beziehung zwischen Mensch und Maschine.

Eine neue Kommunikationsgrammatik

Obwohl immer mehr Menschen diese Revolution erahnen, begreifen die meisten nicht, wie tiefgreifend dieser Wandel sein wird. In dieser diffusen Verunsicherung reagieren viele mit einem gefährlichen Rückschritt. Weltweit erleben wir ein Aufflammen von Nationalismus, ein Anzweifeln und Ablehnen von Fakten und Eliten und eine Flucht in Abschottung und Ablehnung. Diese wachsende Verunsicherung ist eine Herausforderung für Politik, Wirtschaft und Gesellschaft, denn es gilt, einen stabilen Ausweg zu finden. Die digitale Revolution hat, wie wir alle wissen, zum Beispiel unsere Medienlandschaft auf den Kopf gestellt. Als ich im TV begann gab es gerade Mal drei Sender. Heute ist die Medienlandschaft total zersplittert, mit TV-Kanälen, Streaming Diensten oder unzähligen Plattformen. Die Folge der neuen Kommunikationsgrammatik sind Phänomene wie Fake-news und Echokammern, die sich auf diesem vernetzten Nährboden dramatisch ausbreiten. Aus Massenmedien sind die Medien der Massen geworden und dabei hat sich auch die Fließrichtung umgekehrt. Heute sorgen Twitter-meldungen für Schlagzeilen und Bilder aus sozialen Netzwerken erobern die Abendnachrichten im Fernsehen. Was, bedingt durch den technischen Fortschritt in den Medien passiert, also das Abschmelzen klassischer Leitmedien, vollzieht sich gleichermaßen in der Politik. Auch hier sind wir Zeugen einer fragmentierten Parteienlandschaft. Die klassischen Volksparteien schmelzen dahin. In Frankreich sind sie in kürzester Zeit verschwunden CDU/CSU und SPD haben Rekordverluste hinnehmen müssen. Selbst eine „große“ Koalition besitzt inzwischen nur noch eine knappe Mehrheit.

Brauchen wir einen neuen Gesellschaftsvertrag?

Statt diesen Paradigmenwechsel einzusehen versucht man – offensichtlich erfolglos – an der alten Grammatik klassischer Parteikoalitionen festzuhalten. Jeder erkennt zwar, dass dieses Denken nicht mehr funktioniert, jedoch fehlt eben auch hier die Debatte, die den neuen Umständen Rechnung trägt. Wenn Medienlandschaften, Banken oder Wirtschaftssysteme durch ein disruptives Fegefeuer gehen, so wird auch die Art und Weise wie Politik funktioniert sich ändern müssen. Im Zuge dieser epochalen Veränderung benötigen wir einen neuen Gesellschaftsvertrag. Unser klassisches Wirtschaftssystem ist keine tragfähige Basis mehr für eine Zukunft, die Begriffe wie Arbeit, Einkommen oder Erfüllung neu definieren muss. Nie zuvor in der Menschheitsgeschichte war der Mensch in der Lage, seine Gegenwart auf so direkte Weise selbst zu gestalten. Doch was sind unsere Ziele? Streben wir tatsächlich eine reibungslose und bequeme Gesellschaft an, die uns jeden Wunsch in kürzester Zeit erfüllt? Begnügen wir uns immer noch damit, dass Innovationen im Wesentlichen Innovationen einer kleinen reichen Minderheit für eine andere kleine reiche Minderheit sind? Worin besteht die Sinnhaftigkeit unseres Fortschritts und wer profitiert letztendlich davon?

Statt diesen Paradigmenwechsel einzusehen versucht man – offensichtlich erfolglos – an der alten Grammatik klassischer Parteikoalitionen festzuhalten. Jeder erkennt zwar, dass dieses Denken nicht mehr funktioniert, jedoch fehlt eben auch hier die Debatte, die den neuen Umständen Rechnung trägt. Wenn Medienlandschaften, Banken oder Wirtschaftssysteme durch ein disruptives Fegefeuer gehen, so wird auch die Art und Weise wie Politik funktioniert sich ändern müssen. Im Zuge dieser epochalen Veränderung benötigen wir einen neuen Gesellschaftsvertrag. Unser klassisches Wirtschaftssystem ist keine tragfähige Basis mehr für eine Zukunft, die Begriffe wie Arbeit, Einkommen oder Erfüllung neu definieren muss. Nie zuvor in der Menschheitsgeschichte war der Mensch in der Lage, seine Gegenwart auf so direkte Weise selbst zu gestalten. Doch was sind unsere Ziele? Streben wir tatsächlich eine reibungslose und bequeme Gesellschaft an, die uns jeden Wunsch in kürzester Zeit erfüllt? Begnügen wir uns immer noch damit, dass Innovationen im Wesentlichen Innovationen einer kleinen reichen Minderheit für eine andere kleine reiche Minderheit sind? Worin besteht die Sinnhaftigkeit unseres Fortschritts und wer profitiert letztendlich davon?

Wir dürfen keine Angst vor diesen Fragen haben, und wir sollten nicht abwarten, bis ganz andere sie beantworten. In einer verunsicherten Gesellschaft, das zeigt die Gegenwart, mehren sich die Stimmen, die das Postfaktische annehmen oder sogar den Geist der Aufklärung und der Offenheit zur Disposition stellen. Für uns alle steht also viel auf dem Spiel.

Wir brauchen daher diesen kritischen und offenen Dialog. Wer dabei meint, dass wir bereits die Antworten kennen, unterschätzt die Dimension dieser notwendigen Debatte. Diese neue Verantwortung gilt es zu erkennen und es liegt an uns, und nicht an der Maschine oder an den Gesetzen des Marktes eine Antwort zu finden. Wünschen wir uns Offenheit, so wie Picasso es treffend formulierte – Dieses Offensein für jede neue Erkenntnis im Außen und Innen: Das ist das Wesenhafte des modernen Menschen, der in aller Angst des Loslassens doch die Gnade des Gehaltenseins im Offenwerden neuer Möglichkeiten erfährt.

Rede von RY vor der Leibniz-Gemeinschaft am 28.11.2017 Berlin. Eine verkürzte Fassung wurde in der FAZ vom 12.1.2018 veröffentlicht.

[1] “Hey Google is it OK if I eat you?” Initial Explorations in Child-Agent Interaction , MIT, ACM ISBN 978-1-4503-4921-5/17/06. http://dx.doi.org/10.1145/3078072.3084330

[2] Nature 550, 354–359 (19 October 2017) doi:10.1038/nature24270

[3] https://dsgvo-gesetz.de/art-22-dsgvo/

[4] Siehe: http://gutenberg.spiegel.de/buch/monadologie-2790/1

[5] http://www.nature.com/news/biomarkers-and-ageing-the-clock-watcher-1.15014

[6] https://www.nature.com/news/infusions-of-young-blood-tested-in-patients-with-dementia-1.22930